Welcome to Jaehyek's Blog!

Here is my front-end learning path-

Install Tensorflow and OpenCV on Raspberry PI 3

다음의 내용은 Raspberry PI 3 에 Tensorflow을 설치하는 순서를 알려준다.

-

https://ubuntu-mate.org/raspberry-pi/ 에서 Ubuntu Mate을 설치한다.

기본적으로 Python 2.7, 3.5 가 설치되어 있다.

arm7l 용으로 build 되어 있는 tensorflow는 https://github.com/samjabrahams/tensorflow-on-raspberry-pi/releases/

에서 구할 수 있는 데 Python 3.4이다.

( Python 3.5용은 별도로 compile해야 하므로 시간이 많이 걸린다. 거의 할 수 없다. )

해서 miniconda을 설치하면서 Python 3.4을 설치하고 tensorflow for Python 3.4을 설치한다. - miniconda을 설치한다.

https://repo.continuum.io/miniconda/ 에서 Miniconda3-3.16.0-Linux-armv7l.sh 을 다운 받는다.

https://www.continuum.io/blog/developer/anaconda-raspberry-pi 을 참조하면,

$ wget http://repo.continuum.io/miniconda/Miniconda3-3.16.0-Linux-armv7l.sh <br/> $ md5sum Miniconda3-3.16.0-Linux-armv7l.sh <br/> $ /bin/bash Miniconda3-3.16.0-Linux-armv7l.sh - path에 conda/bin을 추가한다.

export PATH="/home/jaehyek/miniconda3/bin:$PATH" -

Tensorflow 을 설치한다.

https://github.com/samjabrahams/tensorflow-on-raspberry-pi 을 참조하여 설치한다.$ sudo apt-get update $ sudo apt-get install python3-pip python3-dev $ wget https://github.com/samjabrahams/tensorflow-on-raspberry-pi/releases/download/v1.0.1/tensorflow-1.0.1-cp34-cp34m-linux_armv7l.whl <br/> $ pip3 install --user tensorflow-1.0.1-cp34-cp34m-linux_armv7l.whl <br/> -

OpenCV을 설치한다.

http://www.emindlab.com/raspberry-pi/opencv-3-1-0-raspberry-pi.html 여기를 참조한다.sudo apt-get update sudo apt-get upgrade sudo apt-get install guvcview synaptic python-dev python-numpy python-scipy python-matplotlib sudo apt-get install python-pandas python-nose build-essential cmake pkg-config sudo apt-get install default-jdk ant libgtkglext1-dev bison libqt4-dev-tools libqt4-dev libqt4-core libqt4-gui v4l-utils sudo apt-get install qtcreator sudo wget http://liquidtelecom.dl.sourceforge.net/project/opencvlibrary/opencv-unix/3.1.0/opencv-3.1.0.zip sudo unzip opencv-3.1.0.zip cd opencv-3.1.0 sudo mkdir build cd build sudo cmake -D CMAKE_BUILD_TYPE=RELEASE -D INSTALL_C_EXAMPLES=ON –D INSTALL_PYTHON_EXAMPLES=ON -D BUILD_EXAMPLES=ON -D CMAKE_INSTALL_PREFIX=/usr/local -D WITH_OPENGL=ON -D WITH_V4L=ON –D BUILD_NEW_PYTHON_SUPPORT=ON -D WITH_TBB=ON .. sudo make sudo make install sudo nano /etc/ld.so.conf.d/opencv.conf /usr/local/lib Press Control + X to save sudo ldconfig sudo nano /etc/bash.bashrc export PKG_CONFIG_PATH=$PKG_CONFIG_PATH:/usr/local/lib/pkgconfig cd opencv-3.1.0/samples/cpp g++ -o facedetect facedetect.cpp `pkg-config opencv --cflags --libs` ./facedetect https://docs.google.com/document/d/1OcVoQi8UJ2bCtJ2nFPkI-eZi9kuQoqthpOwpCpLGwJE/edit?usp=sharing -

Camera을 enable한다. 그리고 확인해 본다

https://larrylisky.com/2016/11/24/enabling-raspberry-pi-camera-v2-under-ubuntu-mate/ 여기를 참조한다.sudo apt-get update sudo apt-get upgrade sudo apt-get install raspi-config rpi-update sudo raspi-config make sure /boot/config.txt start_x=1 gpu_mem=128 만일 다음과 같이 error가 난다면, mmal: mmal_component_create_core: could not find component 'vc.camera_info' mmal: Failed to create camera_info component mmal: mmal_component_create_core: could not find component 'vc.ril.camera' mmal: Failed to create camera component mmal: main: Failed to create camera component mmal: Failed to run camera app. Please check for firmware updates old version을 다운한다. sudo rpi-update 667cfabe63bc663383559ef88317e86f9bd41e45 그리고 다음을 수행한다. git clone https://github.com/raspberrypi/userland.git cd userland ./buildme touch ~/.bash_aliases echo -e 'PATH=$PATH:/opt/vc/bin\nexport PATH' >> ~/.bash_aliases echo -e 'LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/opt/vc/lib\nexport LD_LIBRARY_PATH' >> ~/.bash_aliases source ~/.bashrc sudo ldconfig sudo reboot now 마지막 확인하기 $ raspivid -p 0,0,640,480 -t 0 python에서 opencv을 열어서 확인하기. webcam.py import cv2 def show_webcam(mirror=False): cam = cv2.VideoCapture(0) while True: ret_val, img = cam.read() if mirror: img = cv2.flip(img, 1) cv2.imshow('my webcam', img) if cv2.waitKey(1) == 27: break # esc to quit cv2.destroyAllWindows() def main(): show_webcam(mirror=True) if __name__ == '__main__': main()

-

-

Install Tensorflow on Windows

다음의 내용은 여기을 참조하자.

- Anaconda 설치

- CUDA설치 ( https://developer.nvidia.com/cuda-downloads )

- cuDNN 설치 ver 8.0 경로 추가 : c:\Program Files\NVIDiA GPU Computing Toolkit\CUDA\v8.0

- 관리자 권한에서 다음 실행. conda create -n tensorflow_in_cpu python=3.5 혹은 conda create -n tensorflow_in_gpu python=3.5

- conda 환경 만든 곳에 tensorflow 설치하기

activate tensorflow_in_cpu

pip install tensorflow ( 오류시 pip install tensorflow=0.12.1)

혹은

activate tensorflow_in_gpu

pip install tensorflow-gpu

** pip3으로도 설치가능.

여기서부터 (tensorflow_in_cpu) 환경. 설치 순서 중요

- Pycharm에서 tensorflow project만들기 c:\Anaconda3\envs\tensorflow(_in_cpu)\python.exe을 선택

- tensorflow 버전을 업데이트 시키고 싶다면

- activate로 conda환경 들어 가신 후

- pip install –upgrade tensorflow 혹은 pip install –upgrade tensorflow-gpu

conda install pandas matplotlib scikit-learn

pip install keras

conda install jupyter notebook

-

Tensorflow 0.x => 1.0 Migration Guide

다음의 내용은 여기에서 퍼 왔습니다.

1.0.0rc0 정식 출시에따라 겪게되는 맨붕 사태를 정리해 봤습니다.

Common

초기화 : initialize_all_variables => global_variables_initializer or local_variables_initializer

2017-3-2 삭제 예정. 아직은 경고만 뜹니다만 미리 변경을 추천드립니다.

v0.x 일반적인 코드

saver = tf.train.Saver(tf.all_variables())v1.0.0rc0

saver = tf.train.Saver(tf.global_variables())Saver

all_variables => global_variables

v0.x 일반적인 코드

sess.run(tf.initialize_all_variables())v1.0.0rc0

sess.run(tf.global_variables_initializer())또는

sess.run(tf.local_variables_initializer())write_version tf.train.SaverDef.V1 => tf.train.SaverDef.V2

저장 포멧 변경으로 하위 호환이 사라짐. 하위 호환이 필요없다면 무시 가능

v0.x 일반적인 코드

tf.train.Saver(max_to_keep=200)호환이 필요하다면 다음과 같이 해야함(미지정 시 기본 포멧이 V2로 저장됨)

tf.train.Saver(max_to_keep=200, write_version=tf.train.SaverDef.V1)Summary

전체적으로 summery 관련 함수들이 tf에서 tf.summery로 이동되고 Summery prefix가 삭제되는 형태의 단순 이름 변경.

SummaryWriter => FileWriter

단순히 이름만 변경됨.

v0.x 일반적인 코드

train_writer = tf.train.SummaryWriter('log/', sess.graph)v1.0.0rc0

train_writer = tf.summary.FileWriter('log/', sess.graph)merge_all_summaries => summary.merge_all

단순히 이름만 변경됨.

v0.x 일반적인 코드

merged = tf.merge_all_summaries()v1.0.0rc0

merged = tf.summary.merge_all()scalar_summary => summary.scalar

단순히 이름만 변경됨. 비슷한 류의 summary 함수들 모두 동일하게

*_summary => summary.*v0.x 일반적인 코드

cost_summary = tf.scalar_summary('Cost', cost)v1.0.0rc0

cost_summary = tf.summary.scalar('Cost, cost)Optimizer

softmax_cross_entropy_with_logits

Argument가 암시적 지정 방식을 더이상 지원하지 않습니다. 명시적 지정이 필요합니다.

v0.x 일반적인 코드

cost = tf.nn.softmax_cross_entropy_with_logits(pred, y)v1.0.0rc0

cost = tf.nn.softmax_cross_entropy_with_logits(logits=pred, labels=y)RNN과 RNN에서 많이 쓰는 함수

tf.nn.rnn_cell.* => tf.contrib.rnn.*

패키지명 단순 이동.

v0.x 일반적인 코드

encoDecoCell = tf.nn.rnn_cell.BasicLSTMCell(self.args.hiddenSize, state_is_tuple=True)v1.0.0rc0

encoDecoCell = tf.contrib.rnn.BasicLSTMCell(self.args.hiddenSize, state_is_tuple=True)tf.nn.seq2seq.* => tf.contrib.legacy_seq2seq.*

패키지명 단순 이동. legacy가 붙은걸 봐선 권장하는 방식이 아닐진데… 더 이쁘게 업그레이드 하는 방법 아시는분 추천 부탁드립니다.

v0.x 일반적인 코드

decoderOutputs, states = tf.nn.seq2seq.embedding_rnn_seq2seq( self.encoderInputs, self.decoderInputs, encoDecoCell, self.textData.getVocabularySize(), self.textData.getVocabularySize(), embedding_size=self.args.embeddingSize, output_projection=outputProjection.getWeights() if outputProjection else None, feed_previous=bool(self.args.test) )v1.0.0rc0

decoderOutputs, states = tf.contrib.legacy_seq2seq.embedding_rnn_seq2seq( self.encoderInputs, self.decoderInputs, encoDecoCell, self.textData.getVocabularySize(), self.textData.getVocabularySize(), embedding_size=self.args.embeddingSize, output_projection=outputProjection.getWeights() if outputProjection else None, feed_previous=bool(self.args.test) )tf.split(split_dim, num_splits, value) –> tf.split(value, num_or_size_splits, axis) !!!! 순서 바뀜 !!!!

잘돌아가던 rnn이 업그레이드 후 이상동작을 보인다면 95.135%는 여기가 문제입니다.

v0.x 일반적인 코드

inputs = tf.split(1, seq_length, tf.nn.embedding_lookup(embedding, input_data))v1.0.0rc0

# inputs = tf.split(1, seq_length, tf.nn.embedding_lookup(embedding, input_data)) inputs = tf.split(tf.nn.embedding_lookup(embedding, input_data), seq_length, 1)tf.concat(concat_dim, values) –> tf.concat_v2(values, axis)

다행히 v2 함수가 따로 준비되어서 당분간 기존 함수로도 수정 없이 무난히 동작합니다.

v0.x에 잘돌아가던 코드

output = tf.reshape(tf.concat(1, outputs), [-1, rnn_size])v1.0.0rc0

output = tf.reshape(tf.concat_v2(outputs, 1), [-1, rnn_size])

tensorflow.bloc 공식 발표에 나왔으나 아직 미정리 ㅠㅜ

- tf.pack / tf.unpack –> tf.stack / tf.unstack

- v0.12: stack/unstack 추가, pack/unpack 은 stack/unstack 을 단순 wrapping

- master: pack/unpack 에 deprecated 메세지 추가

- tf.concat(concat_dim, values) –> tf.concat_v2(values, axis)

- v0.12: concat_v2 추가

- master: concat 에 deprecated 메세지 추가

- tf.sparse_split(split_dim, num_split, sp_input) –> tf.sparse_split(sp_input, num_split, axis)

- master: sparse_split(sp_input, num_split, axis) 로 변경

- tf.reverse(tensor, dims) –> tf.reverse(tensor, axis)

- v0.12: reverse_v2(tensor, axis) 추가

- master: reverse 가 바뀌고, v1.0 이후 reverse_v2 가 deprecated 될 예정

- tf.round –> banker’s rounding

- v0.12: 파이썬의 banker’s rounding 으로 변경, 짝수로 반올림/내림

- dimension, dim, ~indices, ~dim, ~axes 키워드 파라미터 –> axis 로 통일

- v0.12: 기존 파라미터와 axis 모두 유지, 향후 기존 파라미터 삭제 예정

- tf.argmax: dimension –> axis

- tf.argmin: dimension –> axis

- tf.count_nonzero: reduction_indices –> axis

- tf.expand_dims: dim –> axis

- tf.reduce_all: reduction_indices –> axis

- tf.reduce_any: reduction_indices –> axis

- tf.reduce_join: reduction_indices –> axis

- tf.reduce_logsumexp: reduction_indices –> axis

- tf.reduce_max: reduction_indices –> axis

- tf.reduce_mean: reduction_indices –> axis

- tf.reduce_min: reduction_indices –> axis

- tf.reduce_prod: reduction_indices –> axis

- tf.reduce_sum: reduction_indices –> axis

- tf.reverse_sequence: batch_dim –> batch_axis, seq_dim –> seq_axis

- tf.sparse_concat: concat_dim –> axis

- tf.sparse_reduce_sum: reduction_axes –> axis

- tf.sparse_reduce_sum_sparse: reduction_axes –> axis

- tf.sparse_split: split_dim –> axis

- tf.listdiff –> tf.setdiff1d

- v0.12: setdiff1d 추가

- master: listdiff 에 deprecated 메세지 추가

- tf.select –> tf.where

- v0.12: where 추가

- master: select 삭제

- tf.inv –> tf.reciprocal

- v0.12: inv –> reciprocal 이름 변경

- tf.SparseTensor.shape –> tf.SparseTensor.dense_shape

- master: shape –> dense_shape 이름변경

- tf.SparseTensorValue.shape –> tf.SparseTensorValue.dense_shape

- master: shape –> dense_shape 이름 변경

- zeros_initializer –> 함수 리턴으로 변경

- master: ones_initializer 와 동일한 리턴 형식으로 변경

- v0.12: TensorFlowEstimator() 가 삭제되었습니다. 대신 Estimator() 가 권장됩니다.

- tf.pack / tf.unpack –> tf.stack / tf.unstack

-

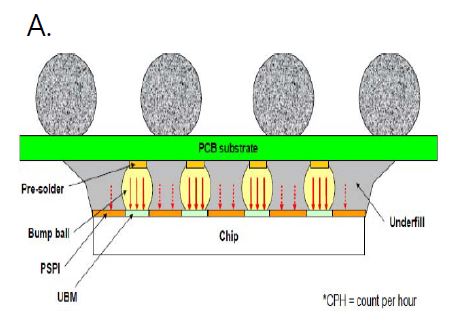

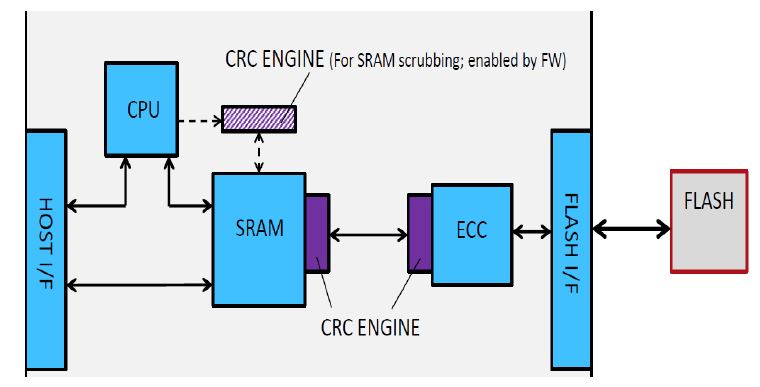

eMMC UFS Issues 17

Component Feature

- Controller :

- Hy

Failure Symptom

- No power-on on smart phone.

- infinite loop booting

Possible Error Type

- NAND Level : bit flip error due to particle or fab error

- FW Level : bit flip from FW error

- emmc internal SRAM Level : bit flip from SRAM unstability

Conclusion after inspection of bit flip

- The NAND level and FW Level have on doubt.

- The cause suspicion is that the bit flip was casused from SRAM data failure , and the data was written to NAND , the wrong data was transferd at booting time.

What is the soft error ?

- is bit flip

- but if rewrite , the error can be recovered.

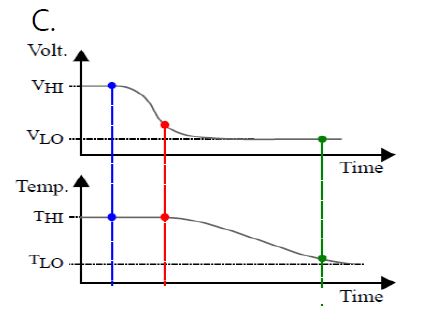

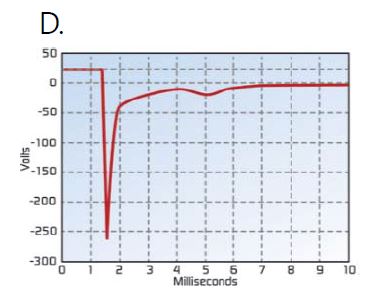

Cause Description A. Alpha particles from package caused by radioactive materials Trace within package B. Cosmic rays creating energetic neutrons and protons caused by high energy from Atmospheric environment C. Thermal The energy stored in the cell is lost over time, as the temperature accelerates and the original data is transformed D. Random Noise or Signal Integrity(Include Current Spike) Random noise and signal integration problem wih power and signal can occurs when the voltage is dropped to under operation voltage Momentarily Instant Voltage Drop on eMMC

- A potent suspect factor

- the evidence

- VCCQ ( 1.2V ) voltage was dropped momentarily between 30nS and 50nS

How to prevent the bit flip on SRAM of eMMC

- install a voltage regulator in front of VCCQ

- detect the instant voltage drop, and then reset system.

- checksum algorithm applying to SRAM

1.In Normal Operation

- Critical management tables are being verified by checksum algorithm

- Before any update or flush to NAND, checksum is calculated and verified

2.In Sleep Mode(cmd5 and AutoSleep )

- While entering and exiting sleep, RAM refresh algorithm is activated

- Read Data –> Detect bit flip –> Recover if needed

- Integrity of data is assured during data flow within the ASIC

- No performace impact

-

Deep Learning summary from http://hunkim.github.io/ml/ (4)

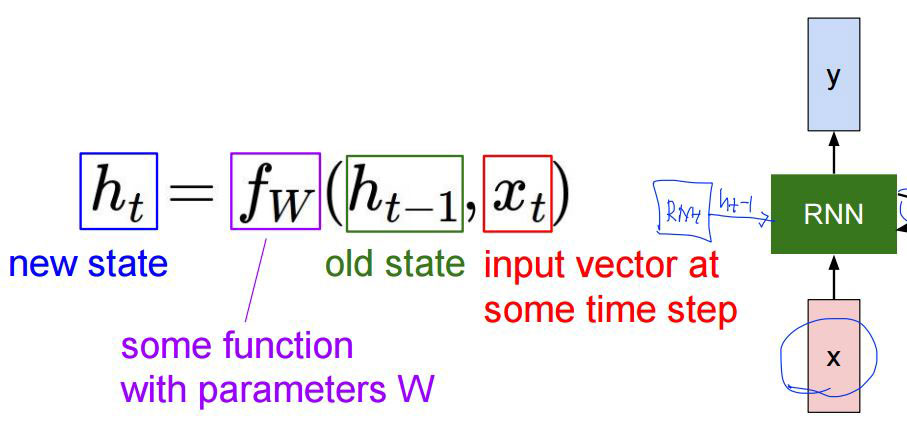

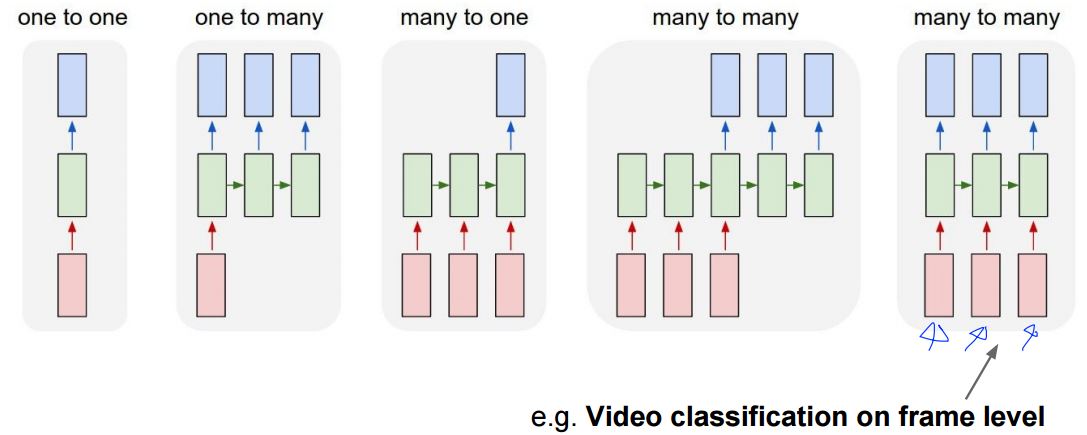

Recurrent Neural Network

refer to http://cs231n.stanford.edu/

-

We can process a sequence of vectors x by applying a recurrence formula at every time step:

-

Notice: the same function and the same set of parameters are used at every time step.

-

-

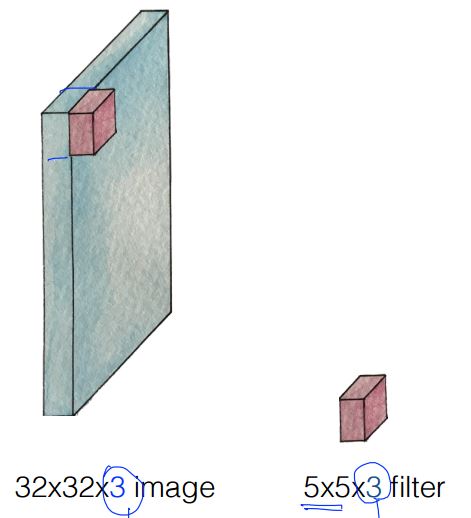

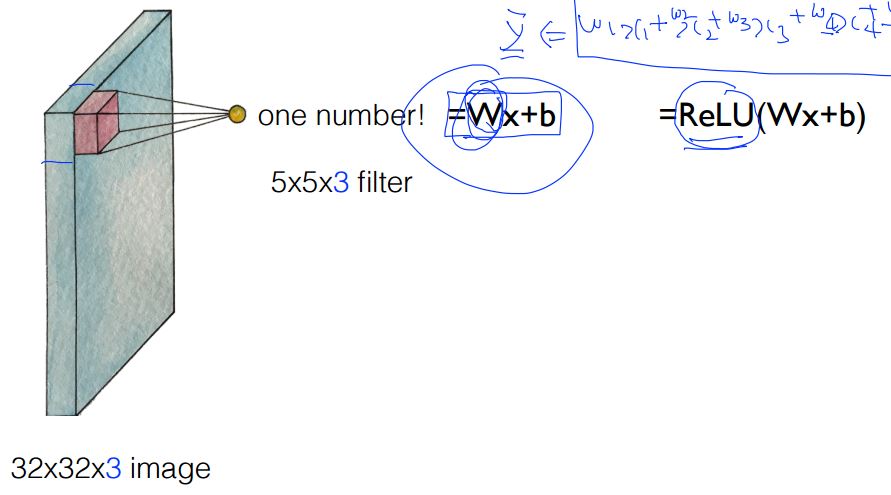

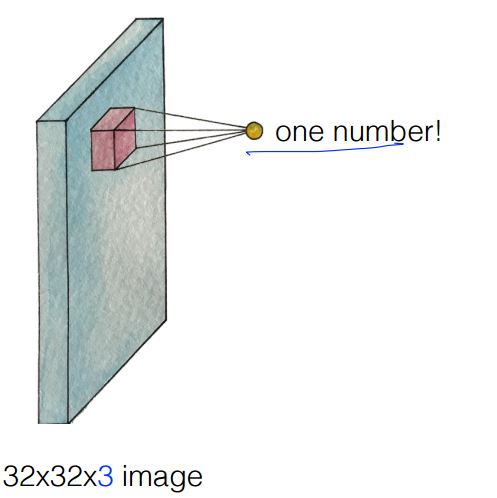

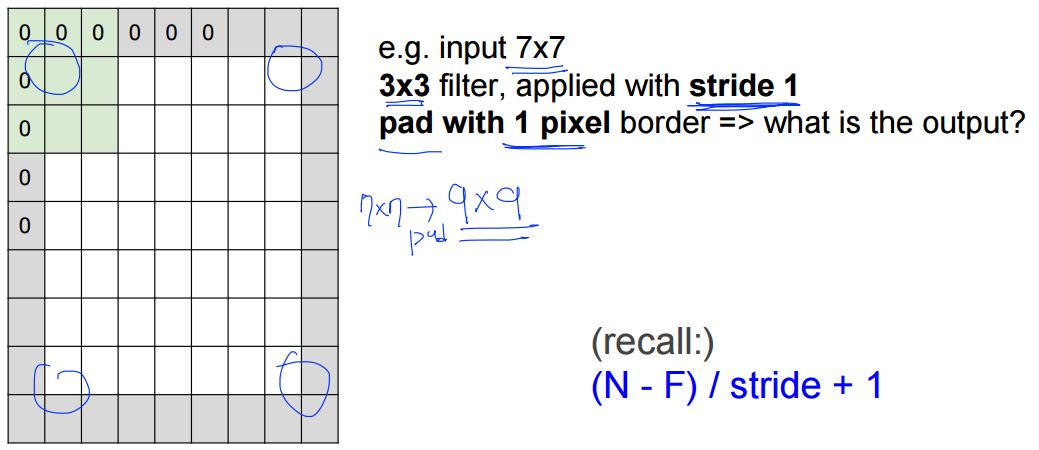

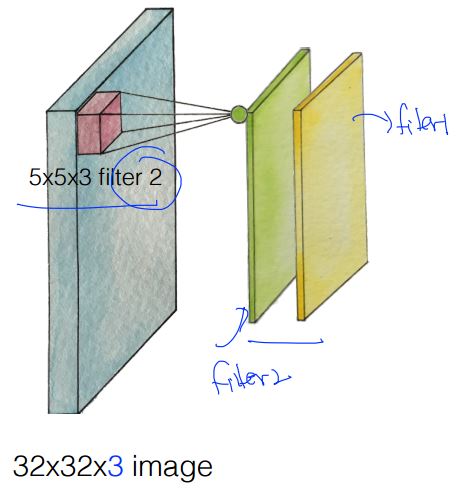

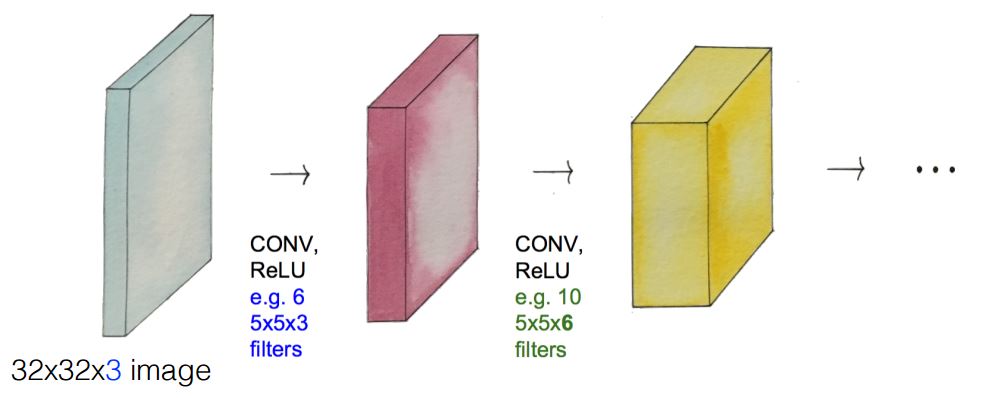

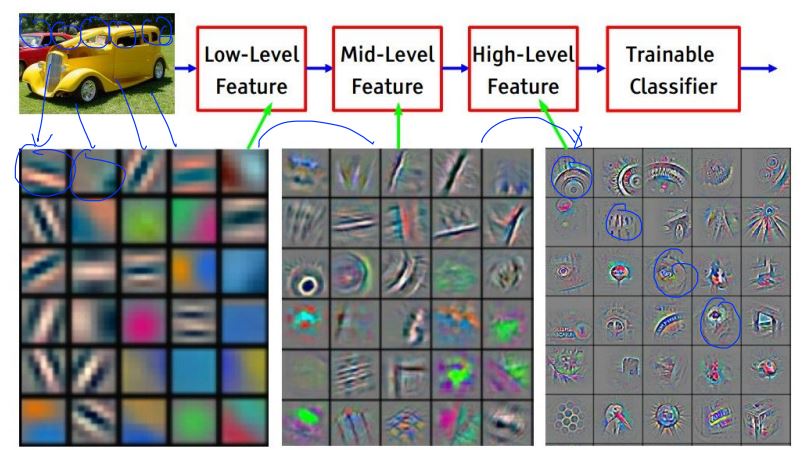

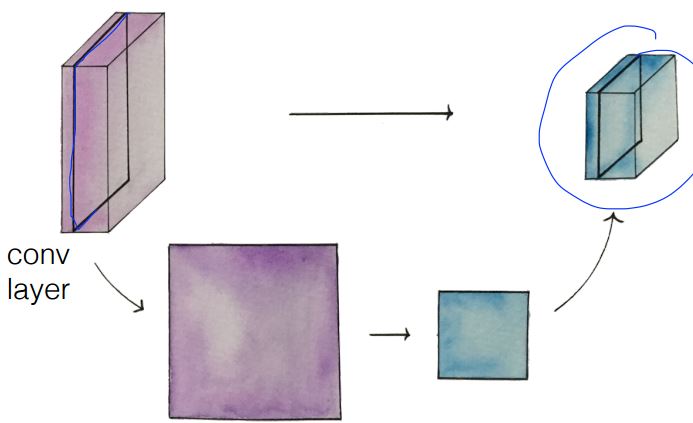

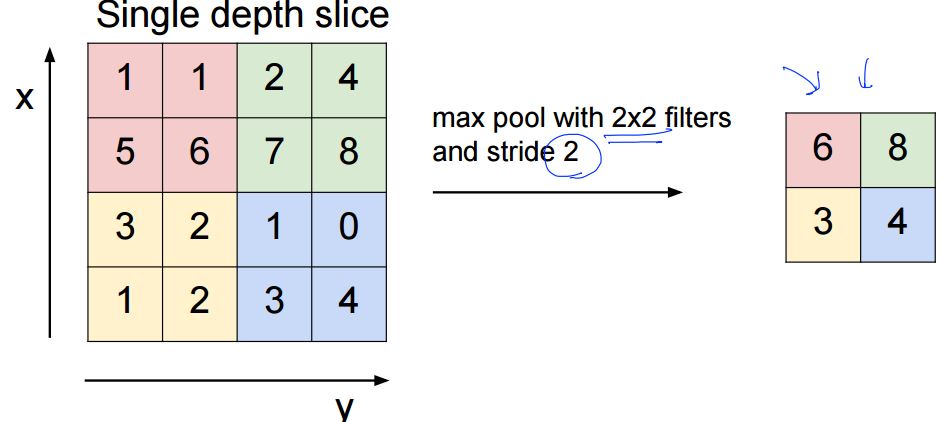

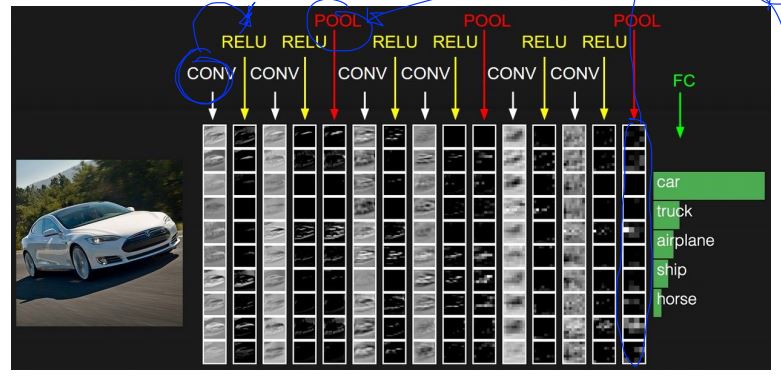

Deep Learning summary from http://hunkim.github.io/ml/ (3)

Convolutional Neural Networks

refer to http://cs231n.stanford.edu/

- Let’s focus on a small area only (5x5x3)

- Get one number using the filter

- Let’s look at other areas with the same filter (w)

- In practice: Common to zero pad the border

- Swiping the entire image

- Convolution layers

- Pooling layer (sampling) & MAX POOLING

- Fully Connected Layer (FC layer) Contains neurons that connect to the entire input volume, as in ordinary Neural Networks

- ConvNetJS demo: training on CIFAR-10]

refer to http://cs.stanford.edu/people/karpathy/convnetjs/demo/cifar10.html

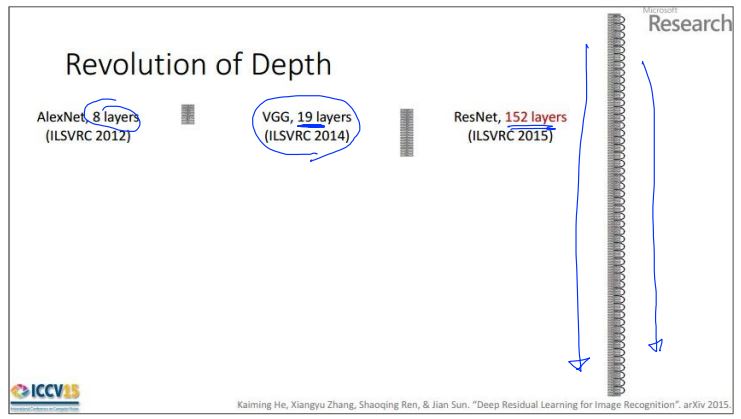

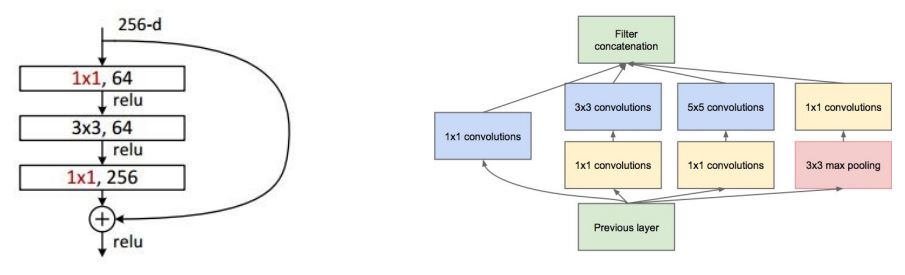

CNN Case Study

Case Study: LeNet-5 [LeCun et al., 1998]

Case Study: AlexNet [Krizhevsky et al. 2012]

Case Study: GoogLeNet [Szegedy et al., 2014]

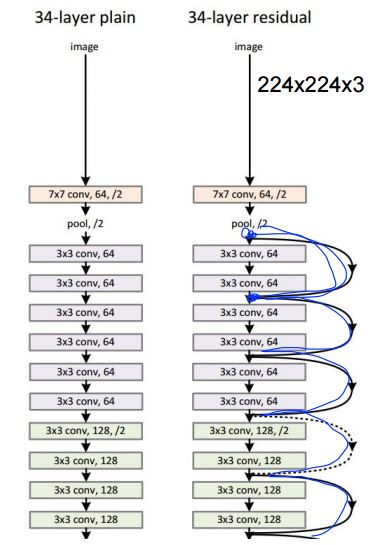

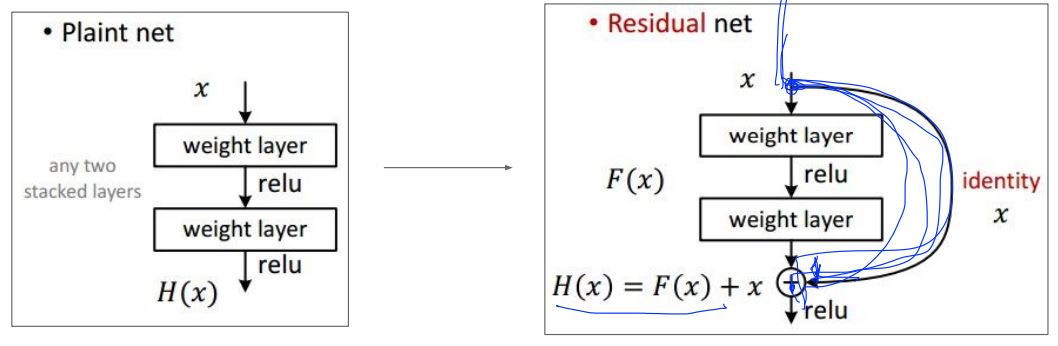

Case Study: ResNet [He et al., 2015]

- Slide from Kaiming He’s recent presentation https://www.youtube.com/watch?v=1PGLj-uKT1w

- ILSVRC 2015 winner (3.6% top 5 error)

- 2-3 weeks of training on 8 GPU machine

- at runtime: faster than a VGGNet! (even though it has 8x more layers)

- Install Tensorflow and OpenCV on Raspberry PI 3

- Install Tensorflow on Windows

- Tensorflow 0.x => 1.0 Migration Guide

- eMMC UFS Issues 17

- Deep Learning summary from http://hunkim.github.io/ml/ (4)

- Deep Learning summary from http://hunkim.github.io/ml/ (3)

- Deep Learning summary from http://hunkim.github.io/ml/ (2)

- Deep Learning summary from http://hunkim.github.io/ml/ (1)

- Summary of CNN base cs231n.github.io

- BOOK-TCP/IP 쉽게 더 쉽게-03